Με τον ερχομό της «μοντέρνας» τεχνολογίας (φωτογραφία) τον 19ο αιώνα και την εκμετάλλευσή της από τα τότε Μ.Μ.Ε. (έντυπες εφημερίδες), εμφανίστηκε όχι τυχαία, και η πρώτη (νομική) μελέτη περί της ιδιωτικότητας από τους S. Warren και L. Brandeis στα 1890 [i] που την προσέγγισαν ως το δικαίωμα κάποιου να αφεθεί μόνος. Η μελέτη εστίαζε στη προστασία από δημοσιοποίηση φωτογραφιών [ii].

Δρ. Κωνσταντίνος Χασάπης, CGEIT

Quality and New Products Development Manager

Algosystems S.A.

Η μοντέρνα σκέψη ακουμπά την ιδιωτικότητα χάρη στον καθηγητή Νομικής A. Westin στα 1967 [iii], που ορίζει την ιδιωτικότητα ως την ικανότητα του ατόμου να καθορίσει το πότε, το πώς, και το ποια ακριβώς θα είναι η πληροφορία που τον αφορά που θα επικοινωνηθεί σε άλλους, και χάρη στον καθηγητή ψυχολογίας I. Altman στα 1975 [iv], που προσεγγίζει την ιδιωτικότητα ως μια διεργασία καθορισμού ορίων, και την ορίζει (αρκετά ευρύτερα) ως τον επιλεκτικό έλεγχο της πρόσβασης στον εαυτό. Παρατηρούμε εδώ μια κλασσική φιλοσοφική διπολικότητα, ο μεν Westin εστιάζει στην ιδιωτική πληροφορία καθαυτή (οντολογική προσέγγιση), ο δε Altman στην ιδιωτικότητα στα πλαίσια κοινωνικών αλληλεπιδράσεων (διεργασιακή προσέγγιση). Παρότι η διαφορά Westin – Altman δείχνει να έχει ενδιαφέρον μόνο εντος ενός κοινωνιολογικού συνεδρίου και όχι ενός περιοδικού IT Security, είναι ιστορικά ειρωνικό πώς η σύγχρονη ασάφεια σε θεωρητικό, νομικό και τεχνολογικό επίπεδο περί της ιδιωτικότητας και της προστασίας της μπορεί να βρει ρίζες στην προαναφερθείσα διπολικότητα.

Ο GDPR [v] έχει εισάγει και έχει «νομικό-ποιήσει» έννοιες όπως «ανώνυμα δεδομένα» (αιτιολογική σκέψη (26)), «ψευδωνυμοποίηση» (αιτιολογικές σκέψεις (26), (28), (29), (75), (78), (85), (156), άρθρα 4.5, 6.4, 25.1, 32.1, 40.1, 89.1), «ταυτοποιημένα ή ταυτοποιήσιμα φυσικά πρόσωπα» (αιτιολογικές σκέψεις (26), (35), (51), (57), (156), άρθρα 4.1, 4.5, 5.1.ε, 9.1, 89.1), και άλλες όπως ο «σκοπός της επεξεργασίας» (υπάρχει σχεδόν παντού και στις αιτιολογικές σκέψεις και στα άρθρα). Επέλεξα ειδικά τις παραπάνω έννοιες και παρέθεσα και τις πολυάριθμες αναφορές τους μέσα στον [v] διότι έχουν άμεση σχέση και με την εναγώνια προσπάθεια του νομοθέτη να ακριβολογήσει αλλά και με την ουσία όσων συζητάμε παρακάτω.

Το ερώτημα που προσπαθώ να ιχνηλατήσω στο παρόν άρθρο είναι το κατά πόσο η νομική προσέγγιση που έχει κύριο στόχο «την προστασία των φυσικών προσώπων έναντι της επεξεργασίας δεδομένων προσωπικού χαρακτήρα (ΔΠΧ)» (άρθρο 1) με χρήση των παραπάνω επιλεγμένων εννοιών, μπορεί να καλύψει ορθολογικά το τεράστιο φάσμα από τεχνικά οριζόμενες «ιδιωτικότητες» που καλώς ή κακώς υφίστανται στα πλαίσια ενός ή πολλαπλών αλληλεπιδρώντων υπολογιστικών συστημάτων και των χρηστών τους.

Ορίζοντας την ιδιωτικότητα

Στα πλαίσια λοιπόν ενός τέτοιου συστήματος ας δούμε πως μπορούμε να ορίσουμε τεχνικά την ιδιωτικότητα που ανά πάσα στιγμή απολαμβάνει ένα φυσικό πρόσωπο. Μια από τις πρώτες αναλυτικές φασματογραφήσεις της ιδιωτικότητας έγινε από τους ερευνητές T. A. Kosa, K. El – Khatib, S. Marsh στα 2011 [vi], όπου σε μια προσπάθεια δημιουργίας μια μεθοδολογίας «μέτρησης της ιδιωτικότητας» όρισαν εννέα διαφορετικές καταστάσεις, και έχτισαν ένα state-model που περιέγραφε τις διάφορες μεταβάσεις μεταξύ καταστάσεων. Οι καταστάσεις εν συντομία είναι:

- Private, 2. Unidentified, 3. Anonymous, 4. Masked, 5. De-identified, 6. Pseudonymous, 7. Confidential, 8. Identified, 9. Public.

Εντός GDPR εμφανίζονται εκπεφρασμένα οι: 8 identified, 6 pseudonymous, και 3 anonymous. Προφανώς ο νομοθέτης δεν θα μπορούσε να καλύψει όλο το φάσμα που έχουν εντοπίσει οι ερευνητές, όμως, και εν όψει του ότι παρακάτω θα μεγαλώσουμε το φάσμα και άλλο, ίσως η επιλογή των τριών καταστάσεων να ήταν λίγο αυθαίρετη, αν έπρεπε καν να γίνει. Αντί λοιπόν για τρεις καταστάσεις οι ερευνητές αυτοί χρειάστηκαν να ορίσουν εννέα ώστε να μπορέσουν να συζητήσουν την μετρησιμότητα της ιδιωτικότητας.

Βαθμός ταυτοποιησιμότητας

Το κύριο μεταβαλλόμενο χαρακτηριστικό στο οποίο βασίστηκαν οι ερευνητές για να ορίσουν τις καταστάσεις ήταν ο βαθμός ταυτοποιησιμότητας (identifiability) ενός φυσικού προσώπου, ο οποίος μεγαλώνει καθώς κινούμαστε από την 1 private προς την 9 public.

Ο νομοθέτης διαισθανόταν ότι το θέμα δεν είναι απλό και ευτυχώς δεν σταμάτησε στο τεχνικό ζητούμενο αλλά πήγε στην ουσία μιλώντας για το «σκοπό της επεξεργασίας». Ειδικά στο άρθρο 5.1.β διαβάζουμε: «Τα Δεδομένα Προσωπικού Χαρακτήρα (ΔΠΧ) συλλέγονται για καθορισμένους, ρητούς και νόμιμους σκοπούς και δεν υποβάλλονται σε περαιτέρω επεξεργασία κατά τρόπο ασύμβατο προς τους σκοπούς αυτούς». Ο νομοθέτης κινείται προς προστασία μιας διάστασης της ιδιωτικότητας που καλύπτεται από το τεχνικό όρο «Unlinkability» [vii, viii]. Η Unlinkability διασφαλίζει ότι τα ΔΠΧ δεν θα μπορούν τεχνικά να διασυνδεθούν μεταξύ διαφορετικών domains (που αντιστοιχούν σε άλλο σκοπό) ή να χρησιμοποιηθούν για άλλους σκοπούς πέρα από τον αρχικό.

Δυο άλλοι ερευνητές, οι J.-M. Bohli και A. Pashalidis στα 2011 ακολουθώντας μια πιο μαθηματική προσέγγιση [ix], σχεδίασαν ένα νοητό (υπολογιστικό) σύστημα στο οποίο ένας επιτιθέμενος προσπαθεί να ανακαλύψει όσα περισσότερα μπορεί για μια ιδεατή συνάρτηση f η οποία δίνει τη ταυτότητα του χρήστη (το φυσικό πρόσωπο) με βάση την έξοδο του συστήματος, ένα μέρος μόνο της οποίας (I) μπορεί να παρακολουθήσει ή εκμαιεύσει ο επιτιθέμενος. Με βάση το βαθμό που η «μαγική» συνάρτηση f παραμένει κρυφή στον επιτιθέμενο, οι ερευνητές ορίζουν ένα φάσμα από καταστάσεις ιδιωτικότητας, οι οποίες «ζουν» στο χώρο και της identifiability και της unlinkability. Για να τις περιγράψουμε θα χρειαστούμε τέσσερις ιδιότητες της συνάρτησης f με βάση τις παρατηρήσεις (Ι) του επιτιθέμενου: U: το σύνολο των χρηστών, Q: Το σύνολο των συχνοτήτων χρήσης του συνόλου χρηστών (δηλ. ποιος χρηστής ήταν πιο ενεργός από ένα άλλο), P: τη linking σχέση, ή, το πόσο οι έξοδοι e μοιάζουν μεταξύ τους, ή, πόσο μοιάζουν οι ομάδες χρηστών μεταξύ τους, οι «τυπικοί» χρήστες δηλαδή (τεχνικά user equivalence classes), C: Πόσο μεγάλη είναι κάθε ομάδα τυπικών χρηστών.

Οι διάφορες ιδιωτικότητες που ορίζονται είναι:

SA, Strong anonymity: Ένα σύστημα που παρέχει SA δεν διαρρέει καθόλου πληροφορία περί την f. Μπορούμε να συσχετίσουμε την SA με κάτι μεταξύ 2 και 3 της προηγούμενης προσέγγισης. Η συσχέτιση δεν μπορεί να είναι ακριβής διότι οι προηγούμενοι ερευνητές μιλούσαν για την ιδιωτικότητα ενός φυσικού πρόσωπου εντός ενός υπολογιστικού συστήματος, ενώ οι εδώ ερευνητές για τη συμπεριφορά όλου του συστήματος καθώς αλληλεπιδρά με ένα επιτιθέμενο.

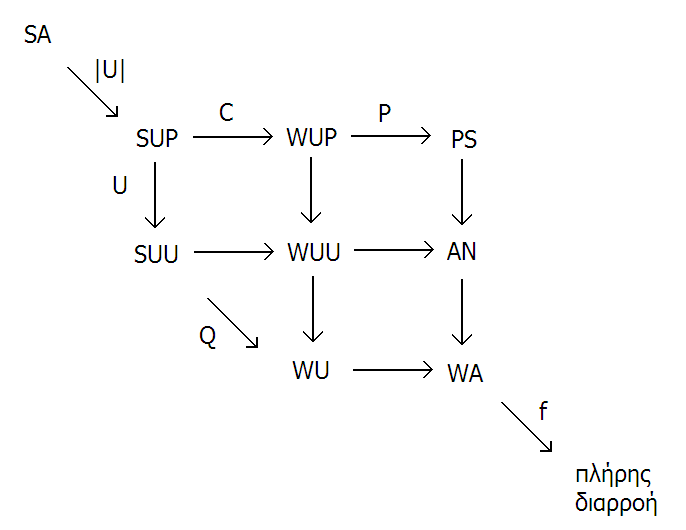

SUP, Strong unlinkability with participation hiding: Ένα σύστημα που παρέχει SUP διαρρέει μόνο το πλήθος των χρηστών |U| SUU, Strong unlinkability with usage hiding: διαρρέει μόνο το σύνολο U. WUP, Weak unlinkability with participation hiding: διαρρέει μόνο το C. WUU, Weak unlinkability with usage hiding: διαρρέει μόνο το U και το C. WU, Weak unlinkability: διαρρέει μόνο το Q. PS, Pseudonymity: διαρρέει μόνο την P. AN, Anonymity: διαρρέει μόνο την P και το U. WA, Weak anonymity: διαρρέει τη P και το Q.

Η σχέση μεταξύ των εννοιών αυτών ξεκαθαρίζει στο σχήμα (τα βελάκια υποδεικνύουν από ποια κατάσταση προς ποια κινούμαστε αν διαρρεύσει η ιδιότητα της f που υπάρχει πάνω στο βελάκι). Στον οριζόντιο x άξονα μπορούμε να διακρίνουμε την αύξηση της Linkability και στο y άξονα μπορούμε να διακρίνουμε την αύξηση της Identifiability.

Συμπερασματικά

Προφανώς «το παιχνίδι αγριεύει» και κανένας μελλοντικός νόμος δεν θα μπορεί να το παρακολουθήσει όσο θα προσπαθεί να παίζει στο γήπεδο της τεχνολογίας. Οι τεχνικές υποπεριπτώσεις θα γίνονται πολλές και θα γίνεται ολοένα και πιο δύσκολο να ξεκαθαρίζουν τα τεχνικά θέματα από τα ουσιαστικά θέματα. Ο μελλοντικός νόμος θα πρέπει να γυρίσει πίσω ξανά σε βαθύτερες και παγκόσμιες κοινωνικές έννοιες και αξίες όπως για παραδείγμα η εμπιστοσύνη και το χτίσιμο αυτής (βλέπε [ii]).

Το θέμα δεν εξαντλείται εδώ. Η πολυδιαστατικότητα του τεχνικού υποχώρου της ιδιωτικότητας ελπίζω όμως να φάνηκε καθαρά. Η Ιστορία για μια ακόμη φορά κοιτά με ειρωνεία την σύζευξη Κοινωνίας – Τεχνολογίας και την αδυναμία της πρώτης να θέσει σωστά (ορθολογικά) εννοιολογικά και νομικά εργαλεία για να αλληλεπιδράσει με τη δεύτερη.

Η Algosystems, είναι ένας έμπειρος System Integrator που εξειδικεύεται σε λύσεις υψηλής τεχνολογίας στον κλάδο της Πληροφορικής, των Aυτοματισμών και της Μετρολογίας. Η εταιρία έχει διαγράψει δυναμική πορεία 32 ετών στην Ελλάδα και 5 ετών στο Κατάρ και εμφανίζει πολλαπλές επιτυχημένες υλοποιήσεις σύνθετων λύσεων σε οργανισμούς κυρίως του ιδιωτικού τομέα, τόσο στην Ελλάδα όσο και στο εξωτερικό. Η Algosystems έχει ενώσει τις δυνάμεις της με την PRIORITY Consultants για να παρέχει αξιόπιστες και δοκιμασμένες λύσεις GDPR που καλύπτουν με αξιοπιστία όλο το φάσμα των εταιρικών αναγκών.

Αναφορές

[i] Samuel D. Warren & Louis D. Brandeis, The Right to Privacy, Harvard Law Review, Vol. 4, No. 5., pp. 193-220, 1890. [ii] Neil Richards, Woodrow Hartzog, Taking Trust Seriously in Privacy Law, Stanford Technology Law Review, Vol. 19: 431-472, 2016. [iii] Alan Westin, Privacy and Freedom, New York: Atheneum, p.7, 1967. [iv] Irwin Altman, The environment and social behavior: Privacy, Personal Space, Territory, Crowding, Brooks – Cole Pub. Co., 1975. [v] Κανονισμός 2016/679 του Ευρωπαϊκού κοινοβουλίου και του συμβουλίου, 27 Απριλίου 2016. [vi] Tracy Ann Kosa, Khalil El – Khatib, Stephen Marsh, Measuring Privacy, Journal of Internet Services and Information Security (JISIS), volume: 1, number: 4, pp. 60-73, November 2011. [vii] F. Bieker, M. Friedewald, M. Hansen, H. Obersteller, M. Rost, “A process for data protection impact assessment under the European general data protection regulation”, published in: K. Rannenberg, D. Ikonomou (eds.): Privacy Technologies and Policy. Fourth Annual Privacy Forum, APF 2016 Frankfurt. Series Title: Security and Cryptology. Series Volume: 9857. Copyright 2016. Publisher: Springer International Publishing. Copyright Holder: Springer International Publishing Switzerland. 2016. [viii] George Danezis, Josep Domingo-Ferrer, Marit Hansen, Jaap-Henk Hoepman, Daniel Le Métayer, Rodica Tirtea, Stefan Schiffner, Privacy and Data Protection by Design, December 2014, European Union Agency for Network and Information Security, www.enisa.europa.eu, © European Union Agency for Network and Information Security (ENISA), 2014. [ix] Jens-Matthias Bohli, Andreas Pashalidis, Relations among Privacy Notions, ACM Transactions on Information and System Security, Vol. 14, No. 1, Article 4, © 2011 ACM. Publication date: May 2011.